00的 XR 周刊 01 - 视觉的空间三维感知

人类视觉和三维感知

人是如何看见东西的呢?

上帝说:要有光。

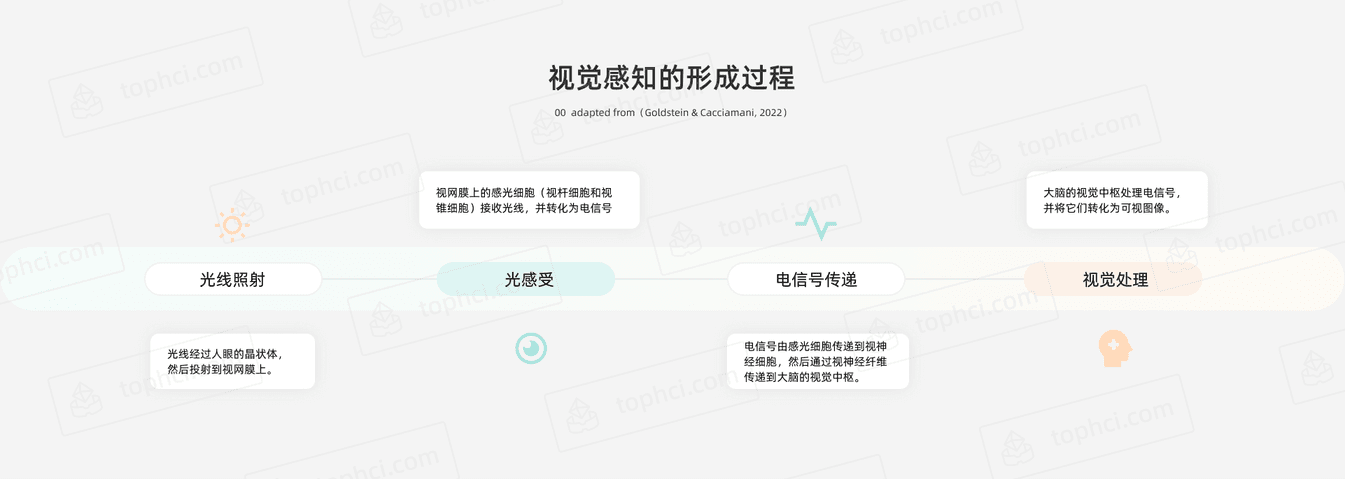

如果用一句话概括就是:人眼接收到物体反射的光线,并转化为神经信号,由神经中枢编码加工后获得主观感觉。人眼在这眨眼瞬间的工作,需要多个步骤协调配合:

就这样,我们「看」到了大千世界。

人的每只眼球大约有 600~800 万个视锥细胞,从视网膜中央向边缘递减分布。在视网膜表面有两个区域:中央凹(fovea)和外围区域(施夫曼,2014)。中央凹在视网膜中心附近,仅占约 1% 的面积,覆盖约 2°~3° 的视角。中央凹虽然只有针孔般大小,却密布着视椎细胞,能够十分准确地检测颜色和空间细节,形成高清晰度图像。

人眼不仅能够看见东西,还能感知三维空间。我们既能看清眼前书页上的小字,也能看见远在光年之外的星星。一个很有趣的问题是:

在视网膜上形成的图像是二维的,那么空间如何被视觉体验为三维呢?

我们用相机拍照片时,其实是用镜头捕捉光线,在成像平面上留下一个投影,以二维图像反映出三维世界的一个快照。而在自然观看过程中,人类的视觉系统则依赖多种「线索」来解释现实环境中物体的外观和相对位置,从而「构建」出三维感知。那么,比二维平面多出来的那一维是什么呢?答案就是深度(depth),即感知到的距离远近。

人类对大部分现实世界的场景有一种直觉的距离感,这是感知空间的基础。深度知觉让我们可以看到三个维度的世界,判断物体与我们之间的远近关系。有时候,这种判断会失效——如果你在旅游景点拍过错位照,就明白我在说什么了。

深度感知线索

人有两只眼睛,相当于两个「镜头」,但不会看到左右两个独立的图像,而是两眼融合后的视觉。当我们环顾四周时,眼睛会收集周围物体的大小、位置、亮度、清晰度和运动等信息。可以将众多帮助形成三维空间感的视觉线索分成两类:

如果更直观地理解二维和三维视觉的区别,想想你去电影院看过的普通电影和 3D 电影吧。普通电影在平面屏幕上投射图像,根据单眼深度线索,如遮挡、相对高度、阴影和运动视差等,创造深度感知。三维电影增加了立体的深度感知。这是通过使用两个并排放置的摄像机实现的。就像你的每只眼睛一样,每台摄像机拍摄的场景视图略有不同。然后将这两幅图像重叠在电影屏幕上。

下面将分别介绍不同的深度感知线索。

单目线索

只需要一只眼睛就可以获得的立体视觉线索。

透视 Perspective

这是视觉感知近处物体与远处物体之间对比差异的能力。有几种透视现象加强了立体空间感:

线性透视 (Linear perspective)最直观也是我们最熟悉的,通过“近大远小”的处理,引入透视点并让视线汇聚,可以明显提高平面上的景深感知。

曲线透视(Curvilinear perspective,又称为鱼眼透视),使用弯曲的透视线而不是直的会聚线来呈现视网膜上的图像。因为视网膜本身是球形的,这比线性透视更准确。

空气透视(Aerial perspective)是一种近处的物体较清晰,远处的物体较模糊的效果。由于受大气中微粒的影响,光线折射后分散开来,不但物体细节的清晰度减少,反射到眼睛里的光线也减少,所以远处的物体往往更近模糊和黯淡。

秋天常常给人一种秋高气爽的感觉。为什么秋天晴朗的天空显得更「高」也更「远」呢?这是因为秋天空气中的水汽、烟尘等微粒较少,远处的光线和物体都更清晰。相反,在雨天和雾气缭绕的时候,我们会感觉建筑和山脉好像都比平时要更远一些。

现在再开一个脑洞:

如果你站在月球上,那里没有大气,远处的地面看起来会是怎么样的呢?

相对大小 Relative size

这是视觉系统根据物体看起来的尺寸差异来判断距离的能力。如果物体大小不变,那么远处的物体相对近处的显得较小。例如,同样一栋房子,房子看起来越小说明它离得越远。另外,大脑还会通过比较物体的感知大小与其典型大小,来估计物体的距离。

相对高度 Relative height

图像中的高度与我们视野中的高度相对应,在视野中更高的物体通常更远。如果有地平线做参考,我们会认为靠近地平线的物体比较远,而远离地平线的物体比较近。

例如,一辆汽车从远处接近地平线的位置移动,如果汽车逐渐高于或低于地平线,它会看起来是在靠近。

遮挡 Occlusion

指一个物体的外表部分或完全遮盖另外的物体。如果一个物体部分遮挡了另一个物体,我们就会认为它距离更近。但它不反映绝对景深或距离信息,仅从遮挡的角度,我们无法判断距离到底有多远。

景深 Depth of field

前景清晰、背景较模糊的景深效果能很好地传达距离信息。例如,可以模糊用户调出菜单后面的背景。这不仅可以模拟现实世界中视觉的自然功能,而且可以防止用户焦点之外的突出物体分散视觉注意力。

光照和阴影 Light & shading

高光和阴影(shading)是感知物体的形状和位置的重要线索:离光源最近的物体表面往往最亮,远离光源或在暗面的物体亮度降低。物体表面上光亮的分布有助于感知物体形状,比如对曲面的感知产生于从明到暗的渐变过程,如果光线突然变暗的部位可能被感知为边缘或拐角。

纹理渐变 Texture gradient

许多物体表面有一些细微结构,给人以不同材质和触感,我们称之为纹理。纹理随着距离远近产生密度变化的视觉效果:附近物体的精细细节清晰可见,而远处物体的纹理元素变小直到看不清。比如,如果仔细观察一块麻布编织毯,重复的图案在远处变得更小更密集。

运动视差 Motion parallax

当头部运动时感知到的差异,不同距离的物体以不同的速度移动,较近的物体似乎比远处的物体移动得更快。运动视差属于单眼线索。在坐火车时这种感觉非常明显:眼前的物体瞬间飞逝,而远处的景物看起来似乎静止不动。

运动视差也常用于在界面动画和视频游戏中,以创造深度和立体感。

调节 Accommodation

眼睛看到物体时,物体反射的光在视网膜上产生一个颠倒的图像。为了使感知的图像清晰地出现在视网膜上,眼睛的睫状肌根据物体的距离变化而随时调整晶状体的形状(屈光率),从而改变焦距以保持清晰的焦点,这个过程被称为调节。

双目线索

双眼深度知觉涉及到左右眼形成的图像的差异,这些线索依赖于双眼协同。如果闭上一只眼睛,大脑就会失去一些用来计算物体深度的信息。

会聚 Convergence

会聚是人在观察物体时两眼之间的夹角,常常又称为辐辏。当视线聚焦在同一个物体上,两个眼球需要相对向内旋转一定角度,以便双目视线相交。当你观看近处的东西,例如一只靠近鼻子的苍蝇时,眼睛会转动聚焦到近处的点。相反,如果无限远的东西,眼睛视线变得平行,几乎不必会聚。

这一类线索基于我们可以感知眼睛位置和眼部肌肉张力的本能,是非常有效的深度信息来源。

视差 Disparity

当双眼注视同一个物体时,左右眼因位置不同会产生视角的差异,左右视网膜成像也会略有不同。视觉系统会自动比较两幅图像,如果足够相似就融合,从而为深度感知提供线索。如果一个物体很远,那么落在两个视网膜上的图像的差异就会很小;如果物体距离很近,则视差会很大。

小结

人类的视觉系统十分强大,从环境中获取了很多信息来构建三维的视觉。各种深度线索汇总如下:

(Doerner 等, 2022)

| 深度线索 | 英文术语 | 类型 | 主要影响距离 | 是否反映绝对距离 |

|---|---|---|---|---|

| 线性透视 | Linear perspective | 单目 | 全部可视范围 | 绝对 |

| 空气透视 | Aerial perspective | 单目 | >30 | 相对 |

| 相对大小 | Relative size | 单目 | 全部可视范围 | 绝对 |

| 相对高度 | Relative height | 单目 | >30m | 相对 |

| 遮挡 | Occlusion | 单目 | 全部可视范围 | 相对 |

| 景深 | Depth of field | 单目 | 全部可视范围 | 相对 |

| 光照和投影 | Light & shading | 单目 | 全部可视范围 | 相对 |

| 纹理渐变 | Texture gradient | 单目 | 全部可视范围 | 相对 |

| 运动视差 | Motion parallax | 单目 | >20m | 相对 |

| 调节 | Accommodation | 单目 | <2m | 绝对 |

| 会聚 | Convergence | 双目 | <2m | 绝对 |

| 视差 | Disparity | 双目 | <10m | 相对 |

从表中我们可以看到,深度线索的影响取决于观察者与物体的距离。有些线索只在近距离时起作用例如调节、会聚;有些在近距离和中距离起作用如运动视差;有些在远距离时起作用如大气透视、相对高度;有些在整个视野内起作用比如遮挡、相对大小。

对于附近的物体,我们主要依赖调节和会聚(辐辏)。如果一个点离观察者越远,它产生的双目视差就越小。在 10 米的距离或许已经很难感知了。

大脑中的深度线索根据不同的任务而起作用。在 XR 场景中,如果不是所有的深度线索都能生成,那么就应该根据用户当前的任务来确定优先次序。例如场景中有一定角度的照明,阴影就很有用。对于在手臂范围内的虚拟物体,应该投入精力优化立体显示的效果。然而,如果物体离观看者超过 3 米远,使用立体显示对空间的感知贡献不大,甚至可能是多余的(Doerner 等, 2022)。

最后,让我们做个练习。对比下面两张图,分别来自 Cities VR 和 Half life:Alyx,想想场景中有哪些深度线索增强了立体感和沉浸感?为什么 3A 大作 Alyx 的场景让人感觉更加真实?

Ref

-

Goldstein, E. B., & Cacciamani, L. (2022). Sensation and perception (11th edition). Cengage.

-

哈维·理查德·施夫曼. (2014). 感觉与知觉(第 5 版) (李乐山 等, Trans.). 西安交通大学出版社.

-

Doerner, R., & Steinicke, F. (2022). Perceptual Aspects of VR. In R. Doerner, W. Broll, P. Grimm, & B. Jung (Eds.), Virtual and Augmented Reality (VR/AR): Foundations and Methods of Extended Realities (XR) (pp. 39–70). Springer International Publishing. https://doi.org/10.1007/978-3-030-79062-2_2

-

Doerner, R., Geiger, C., Oppermann, L., Paelke, V., & Beckhaus, S. (2022). Interaction in Virtual Worlds. In R. Doerner, W. Broll, P. Grimm, & B. Jung (Eds.), Virtual and Augmented Reality (VR/AR): Foundations and Methods of Extended Realities (XR) (pp. 201–244). Springer International Publishing. https://doi.org/10.1007/978-3-030-79062-2_6