AIUX05-意图理解和交互模式演变

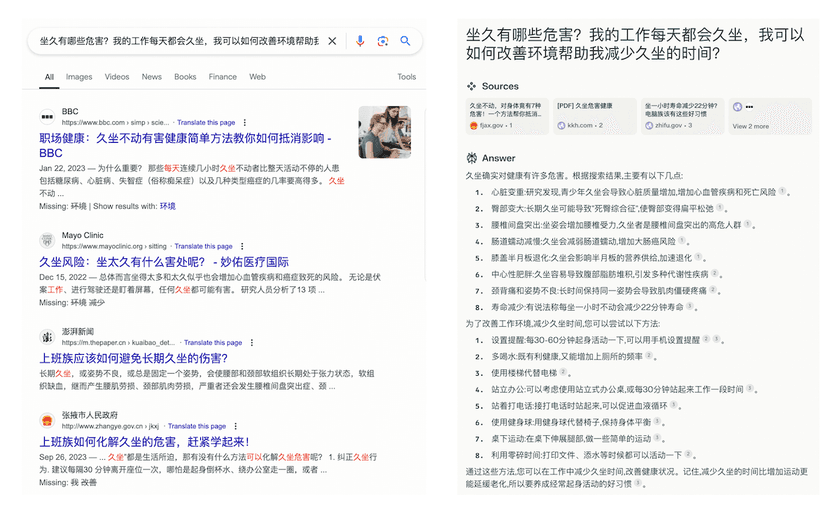

信息获取方式的演变

A cartoon-like drawing of a person working on the computer in front of a squared background —v 6.0 —style raw

回顾信息获取方式的发展,最早的门户网站通过目录和分类来提供信息,显著提高了信息的集中度,聚合了流量。不过用户需要手动浏览和查找,效率不高。后来搜索引擎出现,输入关键词即可匹配相关信息,大大提高了获取信息的效率。不过,搜索引擎依赖用户明确表达的查询意图,难以主动发现潜在需求。

推荐系统的普及再次改变了信息和人的关系。通过分析用户的历史行为和偏好,主动推送用户感兴趣的内容。这个过程不仅依赖技术的进步,比如大数据和机器学习的应用,还受到用户需求驱动。同时商业模式也参与塑造了这一轮变革,个性化推荐不仅提高了用户黏性,还为广告和其他商业服务提供了精准的投放渠道。

如果仅从技术角度考虑意图识别是否可行,也是一个有意思的视角:

- 门户:意图难以获取,只能提供固定的目录让人找信息

- 搜索:用短语表达意图,搜索 query 的意图识别成为关键

- 推荐:从历史数据中挖掘意图,让**信息找人。**由偏好+热度替代意图

对意图的可判断程度,是否也会促进产品形态和交互模式的转变?

bot 是对意图的强制分类,首页 bot 是意图分发

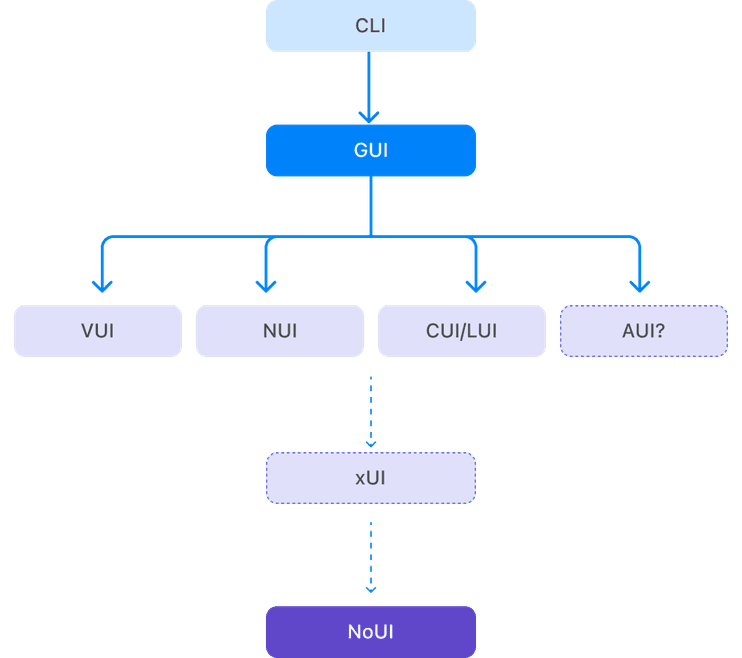

人机交互模式演变

下面让我们拉长时间周期,回顾一下不同的人机交互模式:

| 缩写 | 全称(英文) | 概念/说明 | 交互特性 | 代表产品 | 出现时间 | 发展成熟 |

|---|---|---|---|---|---|---|

| CLI | Command Line Interface | 用户通过输入文本命令与计算机系统交互。 | 精确、快速,适合高级用户和专业任务。 | Unix Shell, Bash, PowerShell | 1960s | 1970-1980 |

| GUI | Graphical User Interface | 使用图形元素(如窗口、按钮、图标)进行人机交互。 | 直观、用户友好,适合大众用户。 | Windows, macOS, GNOME | 1970s | 1990s |

| LUI | Language User Interface | 通过自然语言文本或语音命令与系统交互,有时特指编程语言的接口。 | 适用于编程和复杂查询。 | SQL, Python | 1970s | 1980s |

| CUI | Conversational User Interface | 通过自然语言对话进行交互,包括文本或语音。 | 自然、类似人类对话,支持多轮交互。 | Chatbots, Google Assistant | 1960s | 2010s |

| VUI | Voice User Interface | 通过语音命令进行交互,系统通过语音识别和合成响应用户。 | 方便快捷,特别适合免提操作。 | Amazon Alexa, Google Home | 2000s | 2010s |

| NUI | Natural User Interface | 基于自然动作和手势,如触控、手势控制、体感操作。 | 自然直观,支持多模态交互。 | Microsoft Kinect, HoloLens | 2000s |

趋势:

- xUI 承载的命令:从少到多到无限,

- 输入的指令类型:从严格约束到自然语言到非语言输入,

- 界面的信息容量:从信息密度低到信息密度高到无限

不同交互模式对意图的处理

- CLI:用文本指令集来高度约束意图,意图必须转换成少量的命令

- GUI:图形元素带来操作可能性的指数级增加。通过选中屏幕对象,缩小意图对象的范围,然后用 menu 来承载针对这个元素的可能操作

- NUI:多模态(声音/手势/眼动/控制器)再次带来意图的指数级增加,通过挖掘贴近本能和物理世界规律的指令集,用多样化输出来承载

- CUI/LUI:可理解社会意向性<4 的意图。CUI 在可用性上出现了倒退,因为用户不知道自己可以干什么,也不知道模型可以干什么——你需要对话,而且得相当聪明地对话

- NUI:AGI 超级智能可以对人的意图进行全方位理解和预判

如果用界面所能承载的操作可能性量级作为划分指标,实际上我们只经历了 CLI 和 GUI 两轮更替,而下一轮变革还没到来。GUI 之后,已经陆续出现了语音交互界面(VUI)、自然交互界面(NUI)、CUI(对话交互界面),但它们都没有发展为新的主流模式。我认为人机交互终极会朝着 NUI(No UI)演化,毕竟人跟世界交互不需要 interface,又或者说万物都是人和环境的 interface。GUI 依然主导,NUI 还遥不可及,那么接下来会是什么?

现阶段的设计是线性的,取需求场景中行动的最大公约数,人为挑选出操作的最佳次序和组合。如果要迎接下一轮的人机交互变革,需要界面能够承载更多的操作/意图,同时平衡认知负荷和可用性,最终能根据现实情境自适应。

我们现在也许处在 AUI-Adaptive GUI 的发展时期。